RAFAEL SERRANO 29.AGO.2018

La Carta abierta citada (ver artículo relacionado) pide más investigación para que los sistemas inteligentes sean beneficiosos para las personas y la sociedad. “Tienen que hacer lo que queramos que hagan”, añade, advirtiendo del peligro de que se nos vayan de las manos. Muestras de la misma preocupación son iniciativas como las del gobierno norteamericano o la de DeepMind, que han creado comités de estudio sobre ética de la IA.

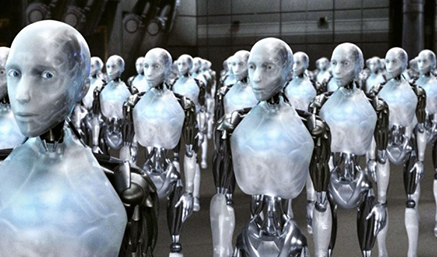

Para que la IA haga el bien y evite el mal no bastarán las leyes enunciadas por Isaac Asimov en Yo, robot. No se puede programar a una máquina con reglas que prevean todas las eventualidades. Tampoco los humanos aprendemos y aplicamos la moral de esa manera, y en las distintas situaciones nos orientamos con nuestra inteligencia natural, sin olvidar la voluntad y los sentimientos.

Dar a una máquina un sentido moral artificial resulta francamente difícil. Están en curso algunos intentos.

El proyecto Good AI, del informático eslovaco Marek Rosa, se basa en entrenar el sistema con ejemplos, como se entrenó Alpha Go con partidas, guiado por un mentor. El fin es que de los casos morales propuestos, la máquina extraiga los valores fundamentales que buscar en nuevas situaciones.

Otro enfoque es el Ethical Adaptor de Ron Arkin, profesor de Ética Informática en el Instituto Tecnológico de Georgia (EE.UU.). Para que los robots interioricen la moral, pretende que imiten no la conducta humana, sino las emociones humanas. Si la máquina, por ejemplo, experimenta una versión artificial del sentimiento de culpa, aprenderá de sus errores y no los repetirá.

Problemas reales

En todo caso, los peligros éticos de la IA no son, al menos por ahora, que las computadoras se rebelen y dominen el mundo. Hay otros más claros y próximos.

Discriminación en la concesión de créditos, la selección de personal, etc. cuando se usa la IA. Unos profesores de Oxford han propuesto que se cree un organismo auditor de algoritmos, que garantice que son imparciales. El Parlamento Europeo, por su parte, estudia la posibilidad de instaurar un derecho a la explicación, para que el candidato disconforme pueda saber por qué le ha descartado el sistema (pero esto exigiría que existiera la XAI [Explainable Artificial Intelligence: ver artículo relacionado]).

Responsabilidad civil. Es un asunto urgente en el caso de los coches sin conductor. En una resolución aprobada el año pasado, el Parlamento Europeo propone crear una “personalidad jurídica electrónica” para robots, a fin de determinar quién debe resarcir por daños en caso de fallo o accidente.

Robots de compañía. En Japón ya han empezado a usarse para atender a ancianos. Boden los considera de muy dudosa ética, al igual que las parejas sexuales artificiales (algo así como la asistente de la película Her), por la misma razón aducida por la resolución del Parlamento Europeo, que señala los peligros para personas vulnerables que desarrollen vínculos afectivos con robots.

Uso bélico. Algunos creen que se debería prohibir los sistemas inteligentes autónomos con poder letal, pues la elección de objetivos y de la fuerza que emplear son decisiones de gran responsabilidad que habrían de ser tomadas siempre por humanos.